LLama 3 405B技术报告解读(二)

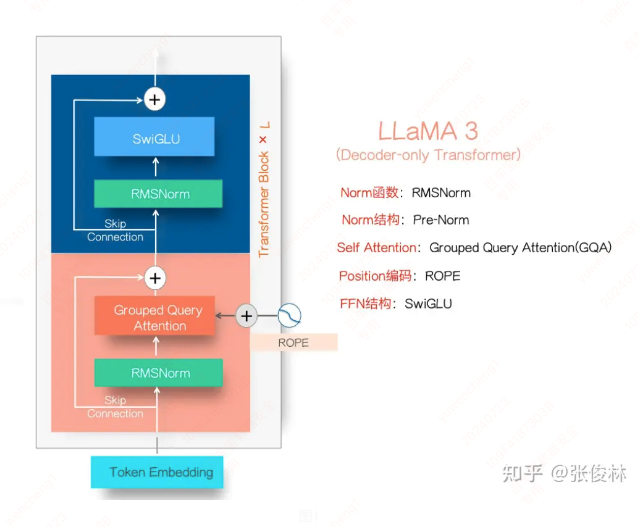

模型结构分析

LLaMA 3的模型结构继续沿用了Transformer架构,这一架构已经成为Dense LLM模型的标准。LLaMA 3的结构包括了自注意力机制和前馈神经网络(FFN),后者采用了SwiGLU激活函数。虽然有些模型采用了专家混合(MOE)结构,但LLaMA 3选择了Dense结构,主要是因为Dense模型训练更稳定,且在性能和可扩展性上表现优异。Meta的技术报告指出,尽管MOE结构在推理成本上有优势,但在训练稳定性和效果上并不如Dense模型[[1]](https://github.com/meta-llama/llama3)[[2]](https://www.ctol.digital)。

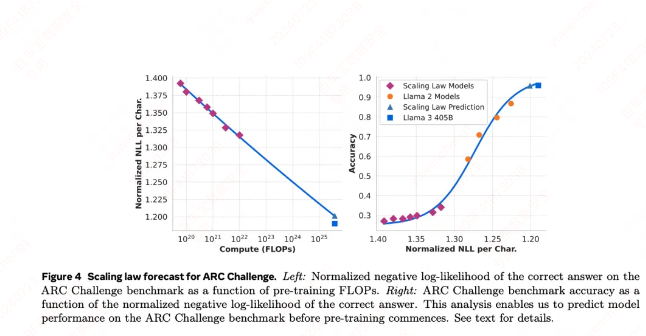

预训练过程

LLaMA 3的预训练过程分为三个主要阶段:

- 初始预训练:标准的预训练阶段,类似于其他LLM模型。

- 长上下文预训练:在训练的后期阶段,使用长文本数据进行训练,支持最长128K token的上下文窗口。

- 退火阶段:在最后4000万个token期间,线性地将学习率退火至0,同时增加高质量数据如数学、代码、逻辑内容的比例[[3]](https://huggingface.co)[[4]](https://techmonitor.ai)。

后训练过程(Post-Training)

LLaMA 3的后训练流程包括人工标注数据训练的RM模型,用于拒绝采样和SFT(监督微调)数据生成。这个过程通过反复迭代,逐步优化模型输出质量。具体步骤包括:

- 使用人工标注数据训练RM模型。

- RM模型对生成的回答进行评分,选择得分最高的作为SFT数据。

- 使用DPO模型调整LLM参数,鼓励输出高质量答案[[3]](https://huggingface.co)[[5]](https://openrouter.ai)。

小模型的崛起

小模型在训练和推理成本、数据隐私保护方面相比大模型有显著优势。提升小模型效果的关键因素包括:

- 增加训练数据的数量和质量:突破Optimal Chinchilla Law,在保证质量的前提下增加数据数量。

- 模型蒸馏:通过大模型作为Teacher,小模型作为Student,学习大模型的预测分布。

- 退火数据:在预训练的最后阶段,上采样高质量数据以提升模型能力[[5]](https://openrouter.ai)。

合成数据的实用化

在后训练阶段,合成数据已经被广泛应用,尤其是在SFT阶段。合成数据质量的提升显著增强了模型的最终效果。此外,合成数据和模型蒸馏本质上都是模型知识传递的一种形式,通过更大的模型生成数据,提升小模型的能力[[5]](https://openrouter.ai)。

影响与展望

LLaMA 3 405B的发布是开源AI领域的一大里程碑,它不仅缩小了开源模型与闭源模型之间的性能差距,还推动了小模型技术的发展。未来,随着更多高质量数据和先进训练方法的应用,小模型的效果将越来越接近甚至匹敌超大规模模型。这一趋势将进一步推动AI技术的普及和应用[[1]](https://github.com/meta-llama/llama3)[[3]](https://huggingface.co)[[4]](https://techmonitor.ai)。

通过LLaMA 3 405B的开源,Meta在AI生态系统中的话语权得到了极大提升,同时也促使其他公司在模型开发和开源策略上作出相应调整。这一发展不仅对研究者和开发者有重要意义,也为整个AI行业注入了新的活力和竞争力[[2]](https://www.ctol.digital)[[5]](https://openrouter.ai)。